Fala, pessoal! 👋

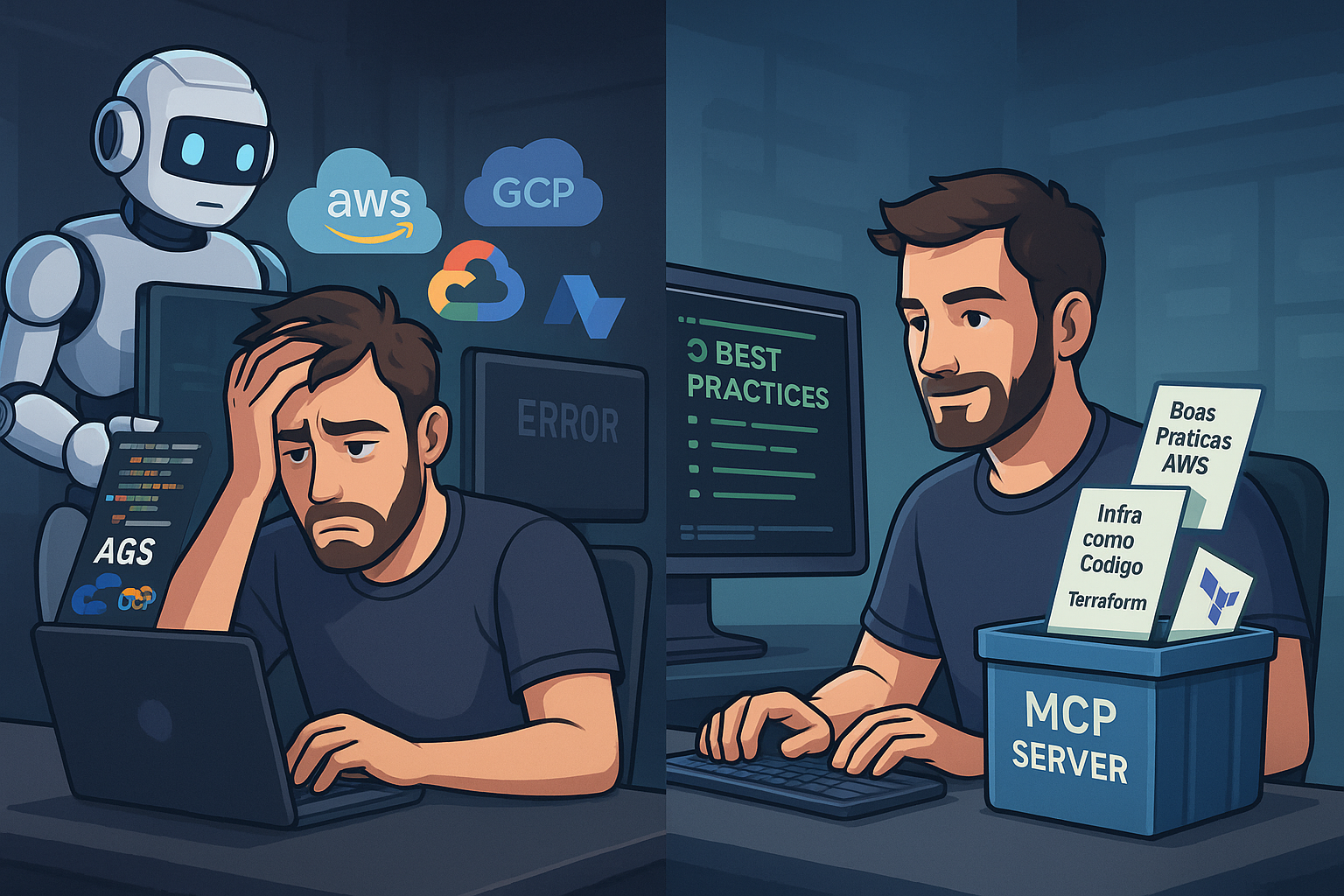

Quem nunca foi com muita sede ao pote, abriu aquele seu LLM favorito (seja GPT, Claude, Gemini, etc), mandou um prompt caprichado e… a resposta veio cheia de linguiça?

Tipo aquelas respostas que fazem parecer que a IA entendeu, mas no fundo ela só ficou tentando te enrolar com um papinho genérico e, quando você olha com atenção, percebe: “isso aqui não tá certo não…”

Pior: já pegou resposta misturando coisas? Você pede algo sobre Load Balancer da AWS e vem resposta falando de NGINX, GCP e ainda insinua que aquilo é recurso nativo da AWS. Aí começa o bug mental: será que eu perdi alguma feature nova ou será que a IA alucinou? 😅

Prompts sem contexto = resposta sem precisão

Não é só sobre produtividade. Quando buscamos ajuda de uma LLM, muitas vezes é porque não dominamos o assunto completamente. A gente quer reduzir o esforço cognitivo, acelerar o desenvolvimento ou até validar se estamos indo pelo caminho certo. Só que sem contexto, não tem milagre.

O prompt pode até estar bem escrito, mas se ele não for enriquecido com boas práticas, padrões e contexto do que você quer, a resposta vai ser… mediana.

E é aqui que entra o MCP.

Mas afinal, o que é MCP?

MCP vem de Model Context Protocol. É um protocolo simples, mas poderoso, que permite adicionar contexto estruturado ao seu prompt. Sabe aquele “jeitinho” de deixar a IA mais esperta? MCP é exatamente isso — só que no modo turbo.

Imagina o seguinte: você quer criar uma infraestrutura na AWS com Terraform. Se você jogar um “cria aí uma EC2 com boa prática” direto pra LLM, ela vai tentar te ajudar… mas baseada no que ela foi treinada meses (ou anos) atrás.

Agora, se você conecta seu prompt a um MCP Server, por exemplo o da AWS + Terraform, ele automaticamente alimenta seu contexto com as melhores práticas atualizadas — direto da fonte. Ou seja: você melhora a qualidade da pergunta sem nem precisar conhecer tudo daquilo.

E onde isso roda?

A beleza é que o MCP Server roda como um container local na sua máquina. Ele se integra com seu ambiente de desenvolvimento (tipo VS Code ou Cursor) e fica lá, sempre disponível pra enriquecer seus prompts, seja em modo “pergunta” ou modo “agente” (onde ele realmente executa coisas no seu ambiente).

Dois exemplos que você precisa conhecer:

🔹 MCP Server da AWS – Ideal pra quem trabalha com serviços como EC2, DynamoDB, Cost Explorer, etc. Ele já vem com boas práticas incorporadas direto da AWS Labs e sabe gerar código, comandos, estratégias e até recomendações atualizadas. (Saiba mais em : https://github.com/awslabs/mcp)

🔹 MCP Server do Terraform – Ele entende como montar providers, configurações de módulos, e até aplicar políticas baseadas em práticas recomendadas. Tem inclusive versões da Hashicorp e da AWS Labs — cada uma com ferramentas diferentes. (Saiba mais em : https://github.com/hashicorp/terraform-mcp-server)

Você pode instalar direto no VS Code, inicializar via Docker e começar a usar com ferramentas como o Copilot, Cline, Amazon Q integrando tudo em segundos.

Por que isso importa tanto?

Porque a qualidade do output da IA está diretamente ligada à qualidade do seu input — e nem sempre temos tempo ou conhecimento pra escrever o melhor prompt possível.

MCP ajuda a preencher essas lacunas. Ele não substitui sua expertise, mas te dá um contexto mais robusto pra trabalhar — seja pra quem está aprendendo ou pra quem quer acelerar sem abrir mão da qualidade.

Inclusive, tem aluno lá na Comunidade de Arquitetura Descomplicada (CAD) que criou uma arquitetura inteira do zero usando MCP, mesmo sem nunca ter implementado na prática. O cara sabia o conceito, plugou os MCPs certos… e o resto foi só pedir.

Conclusão

A próxima vez que você abrir seu LLM favorito e pensar “será que tem como melhorar essa resposta?”, lembra do MCP. Não é só sobre saber perguntar — é sobre dar contexto para receber respostas de verdade.

Se você ainda não testou MCP, essa pode ser a virada de chave na sua jornada com IA. 🚀

Abracos.

Douglas Mugnos